Инструменты с открытым исходным кодом для ИИ

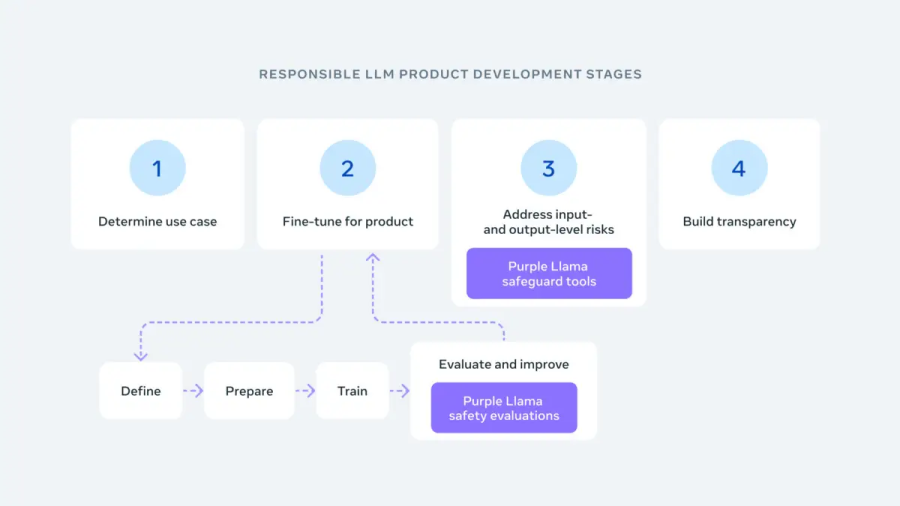

Мета представила Purple Llama, проект по созданию инструмента с открытым исходным кодом для разработчиков, позволяющего оценивать и повышать надежность и безопасность генеративных моделей ИИ до их публичного использования.

Meta заявила, что проблемы ИИ не могут быть решены в одиночку, и подчеркнула необходимость совместной работы в области безопасности ИИ. По словам компании, цель Purple Llama - создать общую основу для разработки более безопасного генеративного ИИ в отношении крупномасштабных моделей роста языка и других технологий ИИ.

Люди, создающие системы ИИ, не могут решать проблемы ИИ в вакууме, поэтому мы хотим выровнять игровое поле и создать масштабный центр открытого доверия и безопасности", - написал Мета в своем блоге.

Гарет Линдал-Уайз, директор по информационной безопасности компании Ontinue, назвал Purple Llama "позитивным и активным" шагом на пути к более безопасному ИИ.

Хотя, несомненно, будут звучать заявления о добродетели и скрытых мотивах в привлечении разработок на платформу, фактическое "немедленное" улучшение безопасности на уровне потребителя будет полезным", - добавил он. Компаниям со строгими внутренними, клиентскими или нормативными обязательствами, конечно, потребуется более тщательная оценка, чем предлагает Meta. Но все, что помогает ограничить потенциальный Дикий Запад, полезно для экосистемы".

Проект включает в себя партнерство с разработчиками искусственного интеллекта, облачными сервисами, такими как AWS и Google Cloud, полупроводниковыми компаниями, такими как Intel, AMD и Nvidia, и компаниями-разработчиками программного обеспечения, такими как Microsoft. Цель сотрудничества - создание исследовательских и коммерческих инструментов для проверки возможностей моделей искусственного интеллекта и выявления рисков безопасности.

Первый набор инструментов, выпущенный Purple Llama, включает CyberSecEval, который оценивает риски кибербезопасности программного обеспечения, созданного искусственным интеллектом. Инструмент имеет языковую модель, которая позволяет выявлять неуместные или вредные тексты, например, обсуждения насилия или незаконной деятельности. Разработчики могут использовать CyberSecEval, чтобы понять, склонны ли их модели искусственного интеллекта создавать небезопасный код или способствовать кибератакам. Исследования Meta показывают, что большие языковые модели часто содержат уязвимый код, что подчеркивает важность постоянного тестирования и улучшения безопасности ИИ.

Llama Guard - еще один инструмент в этом пакете, крупномасштабная языковая модель, предназначенная для выявления потенциально опасных или оскорбительных языков. Разработчики могут использовать Llama Guard для проверки того, что модель не создает и не принимает небезопасный контент, а также для отсеивания запросов, которые могут привести к вредоносным результатам. Агенство Цифровых Решений - Go495.ru